What Wall?Google 发布最新学霸模型 Gemini(Exp 1114)再次屠榜

自2022年 ChatGPT 闪亮登场,AI 江湖的较量就正式打响了!头部厂商竞争激烈,谷歌与 OpenAI 更是两大高手过招,轮流坐庄,成了生成式AI领域的绝代双骄。

这不,谷歌最近又放了个大招,Gemini(Exp 1114)惊艳亮相,在 Chatbot Arena 的评测中,以超越 40 分的巨大提升,一举跃居大模型竞技场排行榜榜首!

在最新的评测中,Gemini(Exp 1114)的排名几乎全线飙升:

• 数学领域:从 #3 升至 #1

• 高难度提示:从 #4 升至 #1

• 创意写作:从 #2 升至 #1

• 视觉识别:从 #2 升至 #1

• 编程能力:从 #5 升至 #3

Google DeepMind 的副总裁兼深度学习负责人,以及 Gemini 的联合负责人对此次升级成果显然是信心满满,直言“what wall?”

数学能力超过 o1

o1 在初次发布时,最令人瞩目的成就之一便是能在博士级别的科学问答中超越人类专家,并具备夺取奥数金牌的实力。而在本次测试中,Gemini(Exp 1114)在数学领域的表现更为出色。

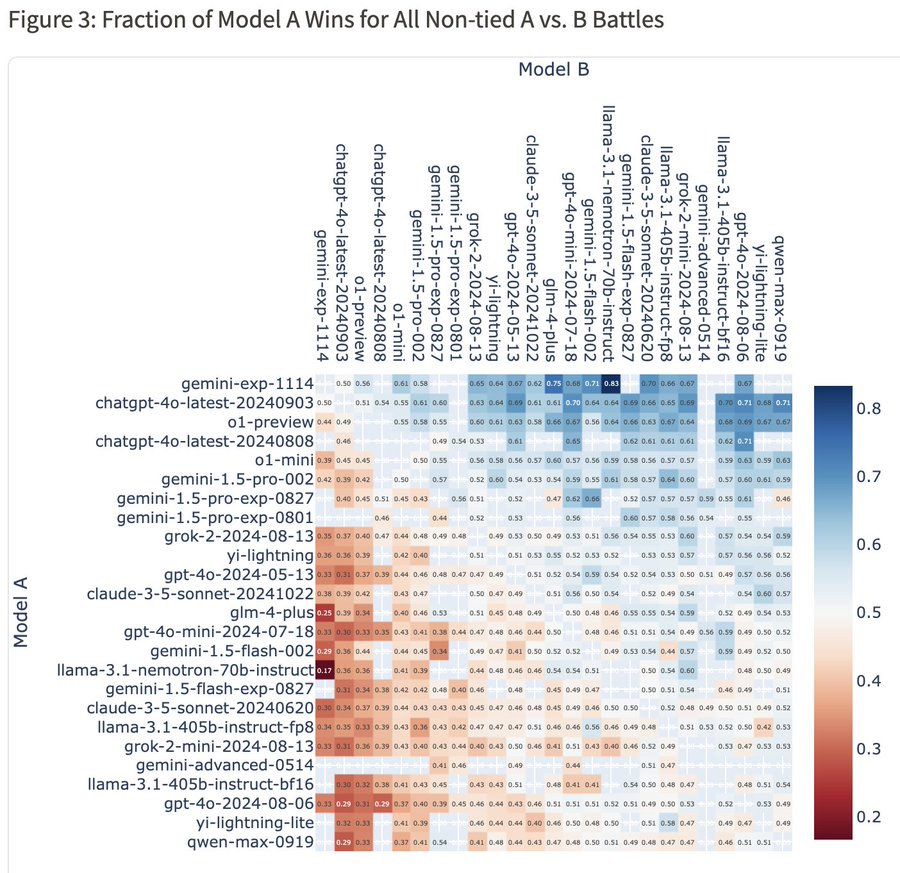

从总体胜率热图上来看,Gemini 对 4o-latest 的胜率为 50%,对 o1-preview 的胜率为 56%,对 Claude-3.5-Sonnet 的胜率为 62%。

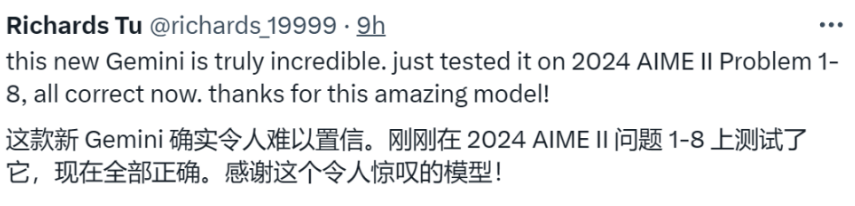

在 AI 发烧友的测评中,Gemini(Exp 1114)正确回答了2024美国数学奥林匹克预选赛II 1-8题。

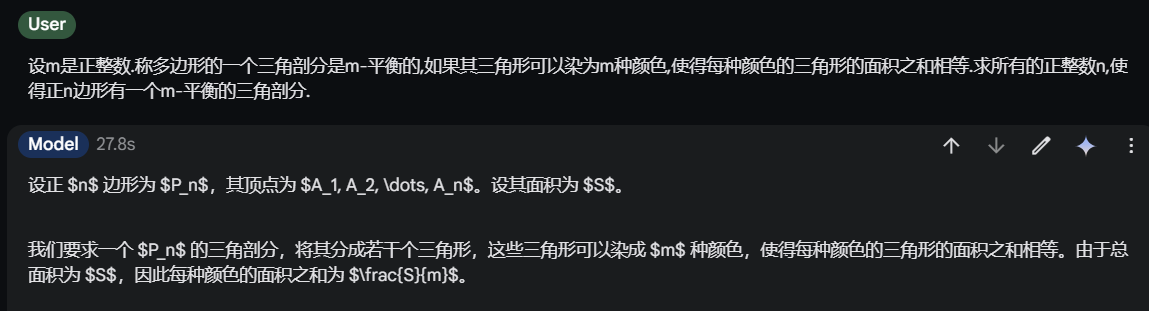

WebEyer 也使用该奥数试卷中第三题进行了试验,Gemini(Exp 1114)于27.8s内正确完成试题。

是个视觉达人

在看图识物方面,Gemini 也是技高一筹。

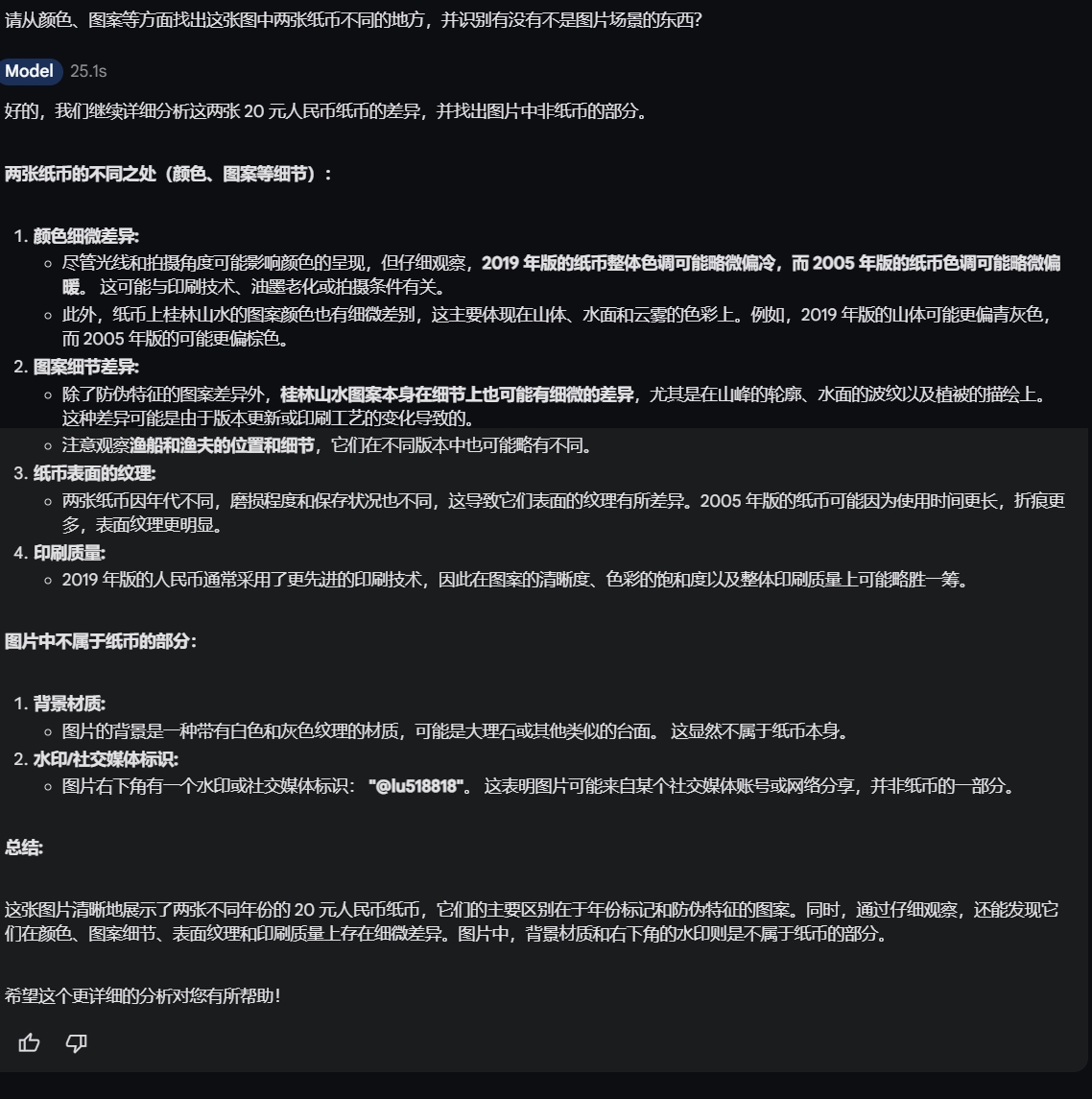

WebEyer 刁钻的使用两张纸币测试这个新的模型。Gemini 的回答也依旧滴水不漏,让人惊艳。为了让大家更直观地感受这一测试的挑战性,我们附上了原图。诚邀各位读者也来尝试挑战 Gemini,看看它的回答能否令你满意。

虽然 Gemini(Exp 1114)在测试中表现亮眼,但也有不少网友吐槽它“答非所问”。比如,有人问它“你叫什么”,它居然回答“Claude”!这不禁让人怀疑,它是不是有点“人格分裂”?

至于是不是传说中的 Gemini 2.0,更是众说纷纭。有人说这是谷歌放出的“烟雾弹”,先拿个“半成品”出来试水,吊足大家的胃口。毕竟,连旧版 1.5 Pro 会的问题它都有可能答不上来,怎么看都不像是个“满级号”。

不管怎么说,Gemini-Exp-1114 仍是目前最优秀的模型之一,其现已可以在 Google AI Studio 上免费试用,如果感兴趣,欢迎大家自行测试。

https://aistudio.google.com/prompts/new_chat